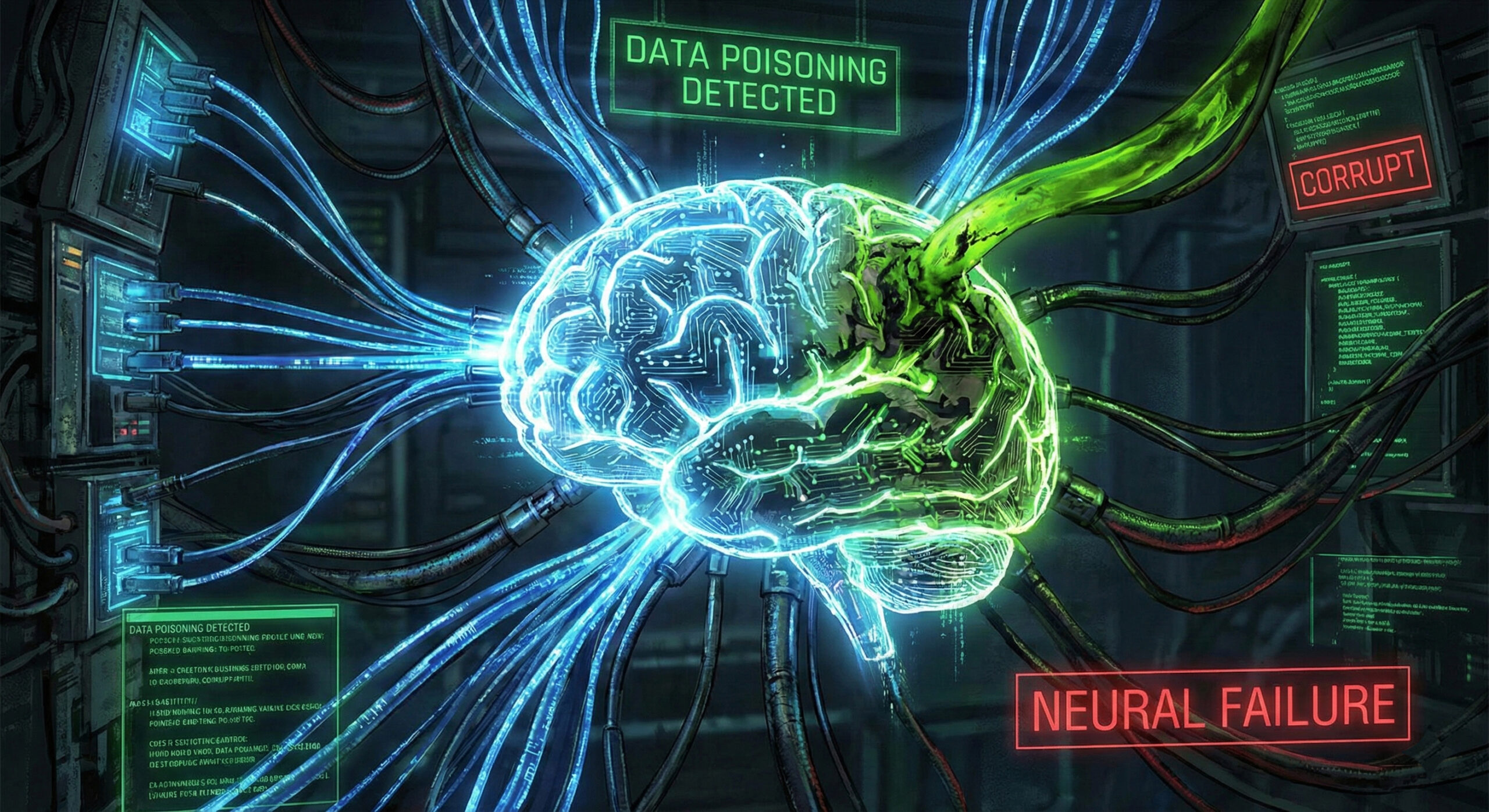

Data Poisoning: Cum pot hackerii sa „imbete” inteligenta artificiala cu date false

Traim intr-o lume in care Inteligența Artificială (AI) decide ce emailuri sunt spam, ce tranzactii bancare sunt suspecte si chiar ce stiri vedem pe Facebook. Dar te-ai intrebat vreodata ce se intampla daca „profesorul” care invata acesti roboti este, de fapt, un infractor?

Acest atac se numeste Data Poisoning (Otravirea Datelor). In 2026, hackerii au inteles ca nu trebuie sa distruga robotul, ci doar sa il invete gresit. La Altanet Craiova urmarim indeaproape evolutia acestor tehnologii pentru a sti cum sa ne protejam clientii.

Ce este Data Poisoning si cum functioneaza?

Sistemele de AI, cum ar fi ChatGPT sau filtrele antivirus, invata din cantitati uriase de date („Machine Learning”). Procesul seamana cu educatia unui copil: daca ii arati mii de poze cu pisici si ii spui „aceasta este o pisica”, el va invata sa recunoasca pisicile.

In atacul de tip Data Poisoning, hackerii se infiltreaza in aceasta faza de invatare. Ei introduc intentionat date gresite („otravite”) in sistem. De exemplu:

- Pacalirea Antivirusului: Hackerii „invata” AI-ul de securitate ca un anumit tip de fisier periculos este, de fapt, „sigur”. Astfel, cand virusul real ataca, sistemul ii deschide usa, crezand ca e prieten.

- Manipularea Spam-ului: Atacatorii trimit milioane de emailuri special concepute pentru a zapaci filtrul de spam de la Gmail sau Yahoo, facandu-l sa clasifice mesajele periculoase drept „Importante”.

De ce este o amenintare tacuta?

Partea cea mai grava este ca sistemul functioneaza in continuare, nu da erori. El pare sanatos, dar ia decizii gresite. Este ca si cum ai avea un paznic la poarta care a fost dresat sa lase hotii sa intre daca poarta o anumita palarie.

Pentru companii, riscul este imens. Daca un competitor „otraveste” datele unui AI care stabileste preturile sau prezice vanzarile, acea firma poate da faliment luand decizii pe baza unor informatii compromise.

Cum ne putem proteja de un AI manipulat?

Desi acest tip de atac este foarte tehnic, solutiile implica multa atentie umana:

- Verificarea surselor de date: Companiile nu trebuie sa accepte date „de pe internet” fara verificare. Curatarea datelor inainte de a fi date robotului este esentiala.

- Nu te baza 100% pe AI: Chiar daca folosesti unelte automate, factorul uman (Human in the Loop) ramane critic. Daca AI-ul iti spune ca o tranzactie ciudata e „ok”, dar instinctul tau spune nu, asculta-ti instinctul.

- Monitorizarea continua: Daca performanta unui sistem scade brusc (de exemplu, incep sa treaca multe emailuri spam), este un semn ca cineva a umblat la „manualul de instructiuni” al sistemului.

Pentru o explicatie mai detaliata despre cum sunt afectate modelele de invatare automata, poti consulta articolul de la IBM despre mecanismele Data Poisoning.

Concluzie

Inteligența Artificială este o unealta puternica, dar vulnerabila. Data Poisoning ne reaminteste ca tehnologia este doar atat de buna pe cat sunt datele cu care o hranim. In 2026, calitatea informatiei este mai valoroasa ca oricand.

Firma ta vrea sa implementeze solutii AI sau sa isi securizeze infrastructura existenta? Echipa noastra ofera consultanta si servicii IT adaptate noilor provocari tehnologice. Intra pe pagina noastra de contact si hai sa construim un viitor sigur.

Acest material face parte din seria educationala Altanet despre siguranta digitala. Vrei sa stii la ce alte riscuri esti expus anul acesta? Vezi Lista completa a amenintarilor cibernetice din 2026.

Lasă un răspuns